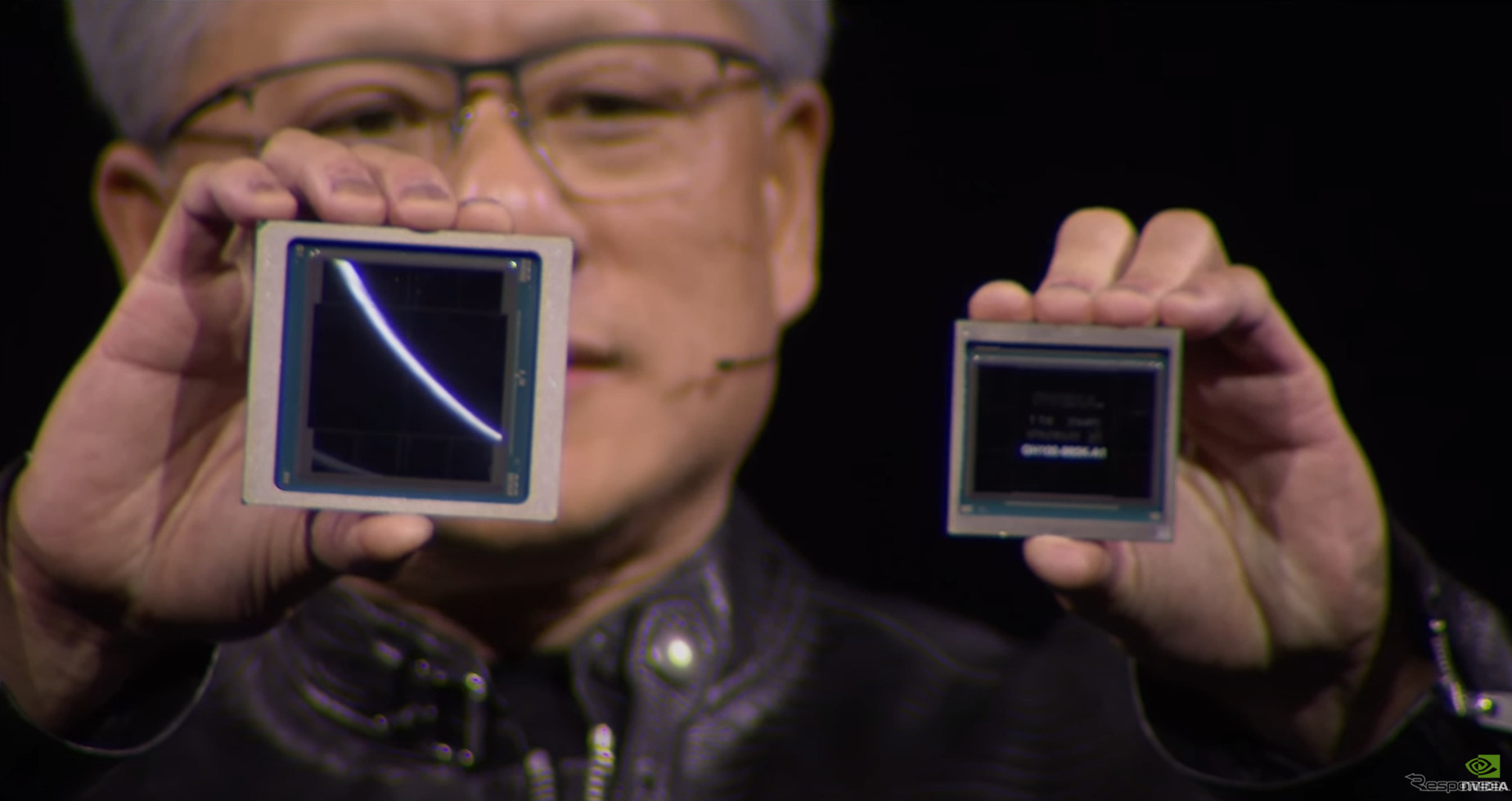

米NVIDIA社は、サンノゼ市でプライベートイベントGTC(GPU Technology Conference)を3月19日(現地時間)から開催。初日のジェンスン・ファンCEOの基調講演では多数の発表が行われた。

◆AIの学習処理能力向上に貢献

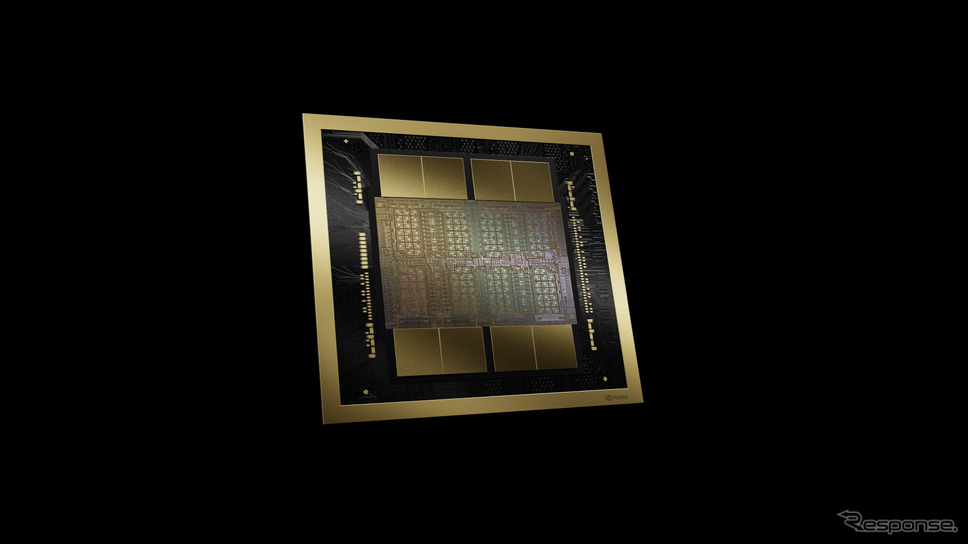

発表は、多岐にわたるが、その中で最も重要なのは、次世代GPUアーキテクチャであるBlackwellである。

同社のGPU(Graphic Processing Unit)は、2年ごとにアーキテクチャ(基本設計)を更新し、性能を高めてきた。Blackwellアーキテクチャは、これから2年間、GPUや車載用プロセッサ、高性能なAIマシンのプロセッサなどに使われる半導体チップの基本設計となるものだ。今回は、具体的なGPUとして「B200 Tensor Core GPU」を公開した。

NVIDIAの製品は、PCなどに使われているGPUのほか、車載コンピュータ、AI用マシン、データセンター用AIサーバーマシンなどに使われる。これらはどれも大量の計算を行う必要がある。新しいアーキテクチャの登場により、これらの製品の性能が向上することになる。

自動運転などに使われるAI(ニューラルネットワーク)の開発には、大量のデータを使った「学習」処理が必要になるが、新しいアーキテクチャの登場により、より多くのデータを使った学習がより短時間で可能になる。こうして作られたAIは、車載用コンピュータなどで動作し、自動運転の物体認識などの「推論」処理に使われる。車載用コンピュータの計算処理性能が向上することで、より大規模で高性能なAIを採用することが可能になる。そういうわけで、新しいBlackwellアーキテクチャの登場により、自動運転にかかわるAI関連の開発がさらに進化することが期待される。

また、GPUを使った高速サーバーなどは、自動車などの設計、デザイン、シミュレーションなどの開発プロセスを高速化する。すでにいくつもの製造メーカーがNVIDIAの製品やサービスを利用しており、自動車を含めた製造業の高度化に寄与すると考えられる。

◆Blackwellの特徴と採用製品

NVIDIAのGPUは、Streaming Multiprocessor(SM)と呼ばれる高速計算を行うモジュールを複数組み合わせて作られる。SMの数を変えることで、半導体チップの構成を変え、目的に合わせた性能を引き出すことができる。

GPUのアーキテクチャは、このSMの数やSMの内部構造で決まる。今回のBlackwellの詳細は発表されていないが、以下のような特徴を持つ。

![日産、米配車サービス大手のウーバーと協業、自動運転車両を供給へ[新聞ウォッチ]](/imgs/sq_l1/2191468.jpg)